マルチモーダルモデルの融合メカニズム分析|テキスト・画像統合学習の設計考察

マルチモーダルモデルの融合メカニズム分析|テキスト・画像統合学習の設計考察

更新日:2025年12月12日

1. マルチモーダル学習の基礎理論

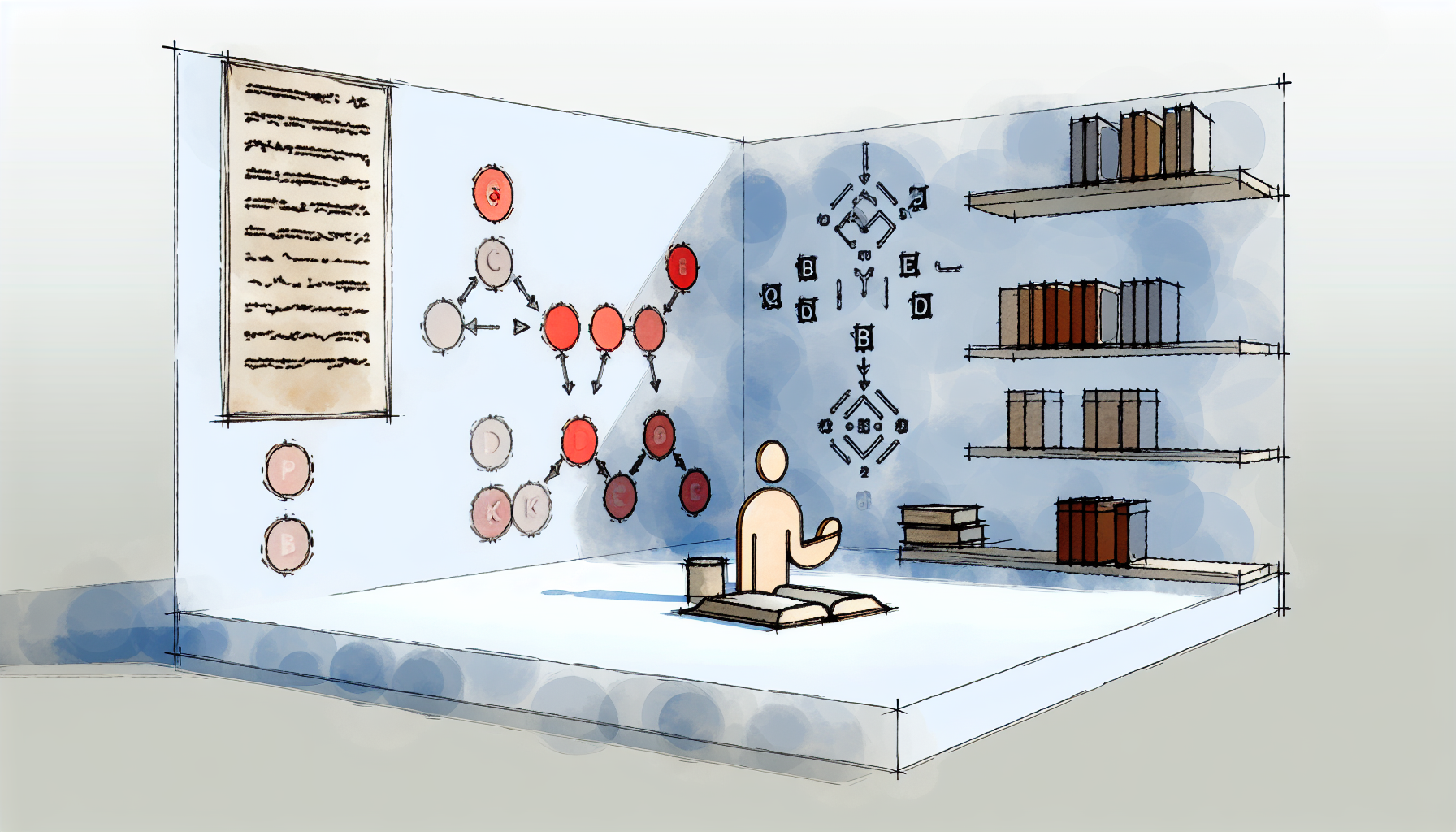

マルチモーダル学習とは、複数の異なる種類のデータ(モダリティ)を統合的に処理する機械学習のアプローチである。人間が視覚、聴覚、言語を組み合わせて世界を理解するように、AIシステムも画像、テキスト、音声などの異なる情報源を融合することで、より豊かな理解と推論が可能になる。

1.1 なぜマルチモーダル融合が重要か

単一モダリティのモデルには本質的な限界がある。テキストのみを処理するモデルは視覚的な情報を欠き、画像認識モデルは意味的な文脈を理解できない。現実世界の情報は本来的にマルチモーダルであり、新聞を読む際にはテキストと画像を同時に処理し、ソーシャルメディアではミーム、キャプション、動画が織り交ぜられている。この認識が、Vision-Language Models(VLMs)の発展を促している。

2025年現在、マルチモーダルAIの成功要因として以下の特性が挙げられる。第一に「真のマルチモーダル統合」であり、画像特徴をテキストモデルに単純に付加するのではなく、両者を深く融合させる設計が求められる。第二に「スケーラビリティ」で、小さな画像から長時間の動画、大規模文書まで処理可能であることが重要となる。第三に「ドメイン適応性」であり、医療画像、財務レポート、科学データなどの専門的文脈に対応できる汎用性が必要とされる。

1.2 マルチモーダルモデルの主要構成要素

Vision-Language Modelsは典型的に3つの主要要素から構成される。

画像エンコーダ(Image Encoder):視覚データから意味のある特徴表現を抽出する役割を担う。Vision Transformer(ViT)やResNetなどが用いられ、画像をパッチに分割して埋め込みベクトルに変換する。例えばViT-L/14では、224×224の画像を196個のパッチ(14×14グリッド)に分割し、各パッチを768次元のベクトルとして表現する。

テキストエンコーダ(Text Encoder):自然言語を処理し理解するために設計される。BERTやGPTなどのTransformerベースのモデルが使用され、トークン列を文脈を考慮した埋め込みベクトルに変換する。

融合機構(Fusion Mechanism):画像エンコーダとテキストエンコーダが学習した表現を組み合わせ、クロスモーダルな相互作用を可能にする戦略である。この融合機構の設計が、マルチモーダルモデルの性能を大きく左右する。

異なるモダリティの特徴は、本来異なる意味空間に存在する。画像の「猫」を表すベクトルとテキストの「猫」を表すベクトルは、単純には対応しない。この「モダリティギャップ」を埋めることが、マルチモーダル学習の中心的課題である。

1.3 マルチモーダル学習の主要課題

マルチモーダル融合には複数の技術的課題が存在する。クロスモーダルアライメントは、異なるモダリティ間で意味的に対応する表現を整列させる問題である。画像中の特定の領域とテキスト中の単語を正確に対応付ける必要がある。

効率的な融合も重要な課題である。画像は数百のパッチトークンを生成し、これをテキストトークンと組み合わせると計算コストが急増する。例えば、ViTで16×16のパッチを使用すると256トークンが生成され、動画理解などではトークン数が爆発的に増加する。

リアルタイム展開とドメイン適応も実用上の課題となる。エッジデバイスでの推論や、特定分野(医療、法律など)への適応が求められる場面が増えている。

2. 融合メカニズムの設計パターン

マルチモーダル融合の戦略は、融合が行われるタイミングによって大きく分類される。Early Fusion、Mid Fusion、Late Fusionの3つの基本パターンがあり、それぞれ異なる特性と適用場面を持つ。

2.1 基本的な融合戦略

特徴抽出の前に異なるモダリティのデータを直接融合する。生のデータレベルで結合するため、モダリティ間の低レベルな相関を捉えることができる。ただし、異なるモダリティの生データは構造が大きく異なるため、直接的な結合が困難な場合が多い。

各モダリティから特徴を抽出した後、特定のメカニズム(特徴連結、重み付けなど)を通じてモダリティ特徴を結合する。特徴空間での融合により、より柔軟な統合が可能となる。現代のVLMsの多くがこのアプローチを採用している。

各モダリティが独立して決定を行った後、その決定結果を統合する。アンサンブル学習に類似しており、各モダリティの専門性を活かしやすい。ただし、モダリティ間の細かな相互作用を捉えることは難しい。

2.2 Attention-based Fusion

Attention機構を用いた融合は、その強力な適応的重み付け能力により、クロスモーダル特徴間の長距離依存関係を効果的に捉える。この選択的統合により、ノイズ、モダリティの不均衡、相補的な手がかりを適切に管理できる。

数学的には、Attention機構は以下のように定式化される。Query(Q)、Key(K)、Value(V)の3つの行列を用いて、入力間の関連度を計算し、重み付き和を出力する。

Attention(Q, K, V) = softmax(QKT / √dk)V

ここでdkはKeyの次元数であり、スケーリング係数として機能する。

Attention-based fusionの主要モデルの発展を時系列で見ると、2019-2020年にViBERT、UNITER、OSCARが登場し、マルチモーダル事前学習のフォーカスが確立された。2021-2022年にはPerceiver、ViLT、ALBEF、AudioCLIP、CoCa、BLIPなどが発表され、手法の多様化が進んだ。2023年以降はImageBind、InstructBLIP、BLIP-2などが登場し、LLMベースのアプローチへのシフトが顕著となった。2024-2025年にはLLaVA-Video、Qwen-Omniなど、より大規模で統合的なモデルが主流となっている。

2.3 Cross-attention機構

Cross-attentionは、一方のモダリティがもう一方のモダリティの情報を参照するための機構である。Self-attentionでは同一モダリティ内でのみ注意を計算するのに対し、Cross-attentionでは異なるモダリティ間で注意を計算する。

具体的には、テキスト表現からQueryを生成し、画像表現からKeyとValueを生成する(またはその逆)。これにより、テキストトークンが画像パッチの情報を選択的に取り込むことが可能となる。

Cross-attentionを用いたモデルとして代表的なのがViLBERTである。ViLBERTは画像領域とテキストセグメントに対して並列に動作する2つのBERTスタイルモデルを持ち、Co-attentional Transformer層を通じて相互作用する。このアーキテクチャでは、画像領域特徴とテキスト特徴を処理するための個別のTransformerがあり、追加のTransformerがこれらの表現を融合する。

2.4 融合戦略の比較

| 融合戦略 | 特徴 | 利点 | 課題 |

|---|---|---|---|

| Dual Encoder + Dot Product | 各モダリティを独立にエンコードし、内積で類似度計算 | 計算効率が高い、大規模検索に適する | 細粒度の相互作用が困難 |

| Co-attention | 双方向の注意機構で相互参照 | 豊富なモダリティ間相互作用 | 計算コストが高い |

| Q-Former | 学習可能なクエリで情報を圧縮 | 効率的なトークン削減、凍結モデルとの統合 | 情報損失の可能性 |

| Interleaved Tokens | 視覚埋め込みをテキストトークンとして処理 | シンプルな実装、既存LLMの活用 | トークン数の増加 |

2.5 Visual Abstractor(視覚抽象化)

動画理解などでトークン数が爆発的に増加する状況では、「Visual Abstractor」が重要な役割を果たす。これは可変数の画像から固定のトークン予算で情報を選択する機構である。

代表的なVisual Abstractorとして、Q-Former(BLIP-2)とPerceiver Resampler(Flamingo)がある。両者とも学習済みクエリとAttentionを用いて、与えられたトークン予算で顕著な視覚情報を選択する。Q-Formerは入力テキストにも条件付けされる点が特徴的である。

より動的な圧縮を可能にする手法も提案されている。Run-Length Tokenization(RLT)は、動画フレーム間で繰り返される連続パッチを識別し、単一のトークンと持続時間エンコーディングで置き換える。この手法はコンテンツを考慮しており、トークン数はフレームの冗長性に依存する。

3. 代表的アーキテクチャと今後の展望

ここでは、マルチモーダル融合の代表的なアーキテクチャを詳しく分析し、それぞれの設計思想と技術的特徴を考察する。

3.1 CLIP(Contrastive Language-Image Pre-training)

OpenAIが2021年に発表したCLIPは、Transformerの注意機構に依存するオープンソースのAIモデルである。Dual Encoderアーキテクチャを採用し、画像エンコーダとテキストエンコーダが独立して動作する。

CLIPの融合機構はシンプルで、グローバルな画像特徴ベクトルとテキスト特徴ベクトル間の内積(ドットプロダクト)で類似度を計算する。この設計により、画像とテキストのペアに対する対照学習が効率的に行える。

CLIPは多様な画像-テキストペアのデータセットで事前学習されており、ゼロショット学習能力を獲得している。新しいクラスラベルに対する明示的な訓練なしにタスクを実行できる点が大きな特徴である。

3.2 BLIP-2とQ-Former

Salesforce Researchが提案したBLIP-2は、凍結された事前学習画像エンコーダとLLMを橋渡しする効率的なアプローチである。中心的なイノベーションは、軽量で学習可能なQuerying Transformer(Q-Former)にある。

Q-Formerは188Mパラメータの軽量モジュールで、BERTbaseの重みで初期化される。32個の学習可能なクエリ埋め込み(768次元)を入力とし、Self-attention層を通じてクエリ間で相互作用し、Cross-attention層(各2番目のTransformerブロックに挿入)を通じて凍結画像特徴と相互作用する。

BLIP-2の学習は2段階で行われる。第1段階では、Q-Formerを凍結画像エンコーダと接続し、画像-テキストペアを用いて学習する。3つの目的関数(Image-Text Contrastive、Image-Grounded Text Generation、Image-Text Matching)を同時に最適化し、クエリがテキストに最も関連する視覚表現を抽出するよう誘導する。第2段階では、凍結LLMと接続し、視覚から言語への生成的学習を行う。

Q-Formerの出力表現Z(32×768)は、凍結画像特徴(例:ViT-L/14で257×1024)よりも大幅に小さく、クエリがテキストに最も関連する視覚情報を抽出することを強制する。これにより、計算効率とモダリティ間の効果的な情報伝達を両立している。

3.3 LLaVA(Visual Instruction Tuning)

LLaVAは、視覚埋め込みを言語モデルへの新しいトークンとして追加するシンプルなアプローチを採用している。画像をパッチに分割し、各パッチの埋め込みをテキストトークンと連結してLLMに入力する。

このアプローチでは、画像を「外国語」として扱い、テキストトークンと同様に処理する。Dosovitskiyらのビジョントランスフォーマー(ViT)で経験的に示されたように、画像はテキストと同じアーキテクチャで処理可能であり、最先端の性能を達成できる。

LLaVAの利点は実装のシンプルさにある。既存のLLMアーキテクチャをそのまま活用でき、Cross-attentionのような新しいパラメータを導入する必要がない。一方で、トークン数の増加による計算コストの課題がある。

3.4 主要モデルの比較

| モデル | 融合方式 | 学習可能パラメータ | 主な特徴 |

|---|---|---|---|

| CLIP | Dual Encoder + Dot Product | 全パラメータ | ゼロショット能力、効率的な検索 |

| ViLBERT | Co-attention Transformer | 全パラメータ | 豊富なモダリティ間相互作用 |

| BLIP-2 | Q-Former | 188M(Q-Formerのみ) | 凍結モデル活用、高効率 |

| LLaVA | Interleaved Tokens | プロジェクタ + LLM微調整 | シンプルな実装、Visual Instruction Tuning |

| Flamingo | Gated Cross-attention | Cross-attention層 | Few-shot学習能力 |

3.5 最新の研究動向(2024-2025年)

2024-2025年のマルチモーダルモデル研究では、いくつかの重要なトレンドが見られる。

MLPアダプタへの回帰:最近のモデルではCross-attentionよりもMLPアダプタが好まれる傾向にある。Qwen-VL2、LLaMA 3.2-Vision、PaliGemma 2、DeepSeek-VLなどがMLPアダプタを採用している。MLPではトークン長の制御が容易であり、複数の視覚エンコーダ埋め込みを同一の入力埋め込みに投影することでトークン圧縮が可能となる。

Multi-Layer Feature Fusion:視覚エンコーダの複数層から特徴を融合する手法が注目されている。単一層の出力だけでなく、異なる抽象度の特徴を組み合わせることで、より細粒度の視覚-言語理解が可能となる。

軽量化と効率化:エッジデバイスやモバイルプラットフォームでのリアルタイム処理を可能にするため、軽量な融合アーキテクチャの研究が進んでいる。Mistralのような軽量モデルは、スマートグラス、ARヘッドセット、車載アシスタントなどでの活用が期待されている。

3.6 今後の研究方向

マルチモーダル融合の将来展望

- クロスモーダル自己教師あり学習:ラベルなしデータからのロバストなマルチモーダル表現学習

- 構造化空間記憶:環境モデリングによる空間知能の強化

- 敵対的ロバスト性:マルチモーダル入力に対する攻撃への耐性強化

- 人間フィードバック統合:倫理的に整合したシステム展開のためのRLHF拡張

- 動的トークン圧縮:コンテンツに応じた適応的な視覚トークン削減

マルチモーダル融合の理論的理解と実践的実装は急速に進展しているが、多くの課題が残されている。異なるモダリティ間の最適なアライメント手法、計算効率とモデル性能のトレードオフ、様々なドメインへの汎化などが継続的な研究課題である。これらの課題の解決は、より知的で汎用的なAIシステムの実現に不可欠である。

本記事は2025年12月12日時点の情報に基づいて作成されています。技術の進展は予測困難であり、本記事の分析が最新の研究動向を完全に反映していない可能性があります。記事内容は個人的な考察に基づくものであり、専門的な判断については関連分野の専門家にご相談ください。重要な技術的決定については、原著論文や公式ドキュメントを参照し、複数の情報源を確認することを推奨します。

他の記事を見る(30件)

- 中国のAI技術革新:オープンソースのエンドツーエンド自動運転システムApolloFM

- AI2027レポート考察2025|元OpenAI研究者が描く3年後の衝撃シナリオ

- AutoCAD AI操作考察2025|技術的現実と競合分析から見る完全自動化への道筋

- AutodeskニューラルCAD考察2025|AI設計革命で見えた40年ぶりCAD大転換

- 言語モデルと脳の乖離研究2025|CMUが解明した人間とAIの3つの決定的な違い

- AI時代に必要なスキル完全ガイド2025|生き残るための10の必須能力

- AIエージェント長時間稼働考察2025|GPT-5・Claude 4が示す数時間推論の新時代

- AI視覚的コンピュータ操作2025考察|18ヶ月で6倍性能向上の衝撃と未来展望

- Google研究:Nested Learning考察|壊滅的忘却を克服する新しい機械学習パラダイム

- China's AI Breakthrough: New Model Surpasses DeepSeek in Cost Efficiency

- China's AI Breakthrough: New Model Surpasses DeepSeek in Cost Efficiency

- NTT空間ノイズキャンセリング技術考察|イヤホン不要で室内全体を静音化する革新

- Google SIMA 2考察|Gemini統合による汎用AIエージェントの革新

- Sakana AI考察|自己改善するDarwin Gödel Machineが示すAI進化の新たな地平

- 【中学生向け】AIってなに?身近な例から学ぶ人工知能入門

- Google Antigravity発表考察|AI IDE競争の新局面とCursor・Windsurf比較

- Google Antigravity機能考察|エージェントファーストが変える開発体験

- AIベンチマーク完全ガイド2025|23種類の評価指標を徹底解説

- AIエージェントの自律性考察|従来型AIとの決定的な違いとは

- Claude「Soul Document」発見の考察|AIの人格設計という新領域

- 2026年AI動向考察|エージェント普及と学習データ枯渇が示す転換点

- Claude 4.5とGPT-5の推論能力比較考察|ベンチマークから見る実力差

- Agentic AI Foundation設立考察2025|AnthropicがMCPを寄贈しAIエージェント標準化へ

- AI時代のエンジニアに求められる基礎知識検討|統計学の重要性

- 機械学習の汎化能力考察|訓練誤差と汎化誤差の関係性

- マルチモーダルモデルの融合メカニズム分析|テキスト・画像統合学習の設計考察

- Transformer以後のアーキテクチャ動向検討|State Spaceモデルの可能性評価

- 注意機構の複雑性削減研究考察|線形注意メカニズムの実用性評価

- Claude MCP エコシステム分析|外部ツール統合による拡張性の考察

- GPT-5.2の技術的特性と市場動向に関する考察

PR:関連サービス

PR:関連サービス

コメント (0)

まだコメントはありません。