集団意思決定におけるアルゴリズムバイアス考察|多数決と最適化の相克

集団意思決定におけるアルゴリズムバイアス考察|多数決と最適化の相克

更新日:2025年12月13日

1. 集団意思決定の数学的基盤と限界

複数の構成員からなる集団が一つの決定を導き出す過程は、民主主義社会の根幹を成す営みである。しかし、この一見単純に思える作業には、数学的に証明された困難が潜んでいる。本章では、社会選択理論の知見を通じて、集団意思決定の本質的な限界を検討する。

1.1 社会選択理論の誕生と展開

社会選択理論の起源は18世紀フランスに遡る。数学者ジャン=シャルル・ド・ボルダは、多数決制度における票の割れの問題を指摘し、選択肢に順位付けして点数を配分するボルダルールを提案した。続いてコンドルセは、ルソーの一般意志概念を念頭に置きながら、多数決の確率論的分析を行った。この時期に提起された問題意識は、約150年後の20世紀中葉、ケネス・アローによって革新的な形で再定式化される。

選択肢に順位を付けて投票し、1位に最高点、以下順次点数を下げて配点する方法。例えば3つの選択肢であれば1位3点、2位2点、3位1点として集計する。単純多数決と比較して、票の割れによる歪みを緩和する効果がある。

1.2 アローの不可能性定理

1951年、経済学者ケネス・アローは博士論文において、社会的選択理論に衝撃を与える定理を証明した。アローの不可能性定理と呼ばれるこの結論は、3つ以上の選択肢が存在する場合、いくつかの合理的条件を同時に満たす社会的決定方法は存在しないことを示している。

アローが設定した条件は次の通りである。非独裁性として、特定の個人の選好だけで社会的決定が決まってはならない。パレート効率性として、全員が選択肢Aを選択肢Bより好む場合、社会的にもAがBより好まれるべきである。無関係な選択肢からの独立性として、AとBの社会的順序は、第三の選択肢Cに対する選好に影響されるべきではない。定義域の非限定性として、論理的に可能なあらゆる個人的選好の組み合わせが許容されるべきである。

この定理は、物理学における不確定性原理、数学における不完全性定理と並んで、人間の知的営みにおける本質的限界を示すものとして広く認識されている。重要なのは、この定理が民主主義の不可能性を直接意味するのではなく、完璧に公平な投票制度の設計が数学的に不可能であることを示している点である。

1.3 多数決の本質的問題

アローの不可能性定理の帰結として、多数決制度には複数の構造的問題が内在する。コンドルセのパラドックスとして知られる現象では、3人以上の投票者と3つ以上の選択肢がある場合、循環的な選好が発生し得る。すなわち、A対Bでは多数がAを支持し、B対Cでは多数がBを支持し、C対Aでは多数がCを支持するという状況が生じる。この循環により、社会的に最も望ましい選択肢を特定することが不可能になる。

| 多数決の問題類型 | 内容 | 発生条件 |

|---|---|---|

| コンドルセのパラドックス | 選好の循環が発生 | 3つ以上の選択肢、多様な選好 |

| 票の割れ | 類似候補への票分散 | 類似選択肢の存在 |

| 戦略的投票 | 真の選好と異なる投票 | 投票結果の予測可能性 |

| アジェンダ操作 | 議題順序による結果操作 | 逐次的投票手続き |

中村の定理は、選択肢の数と意思決定ルールの関係をより一般的に示している。多数決の中村ナンバーは通常3であり、これは2つまでの選択肢からは適切に選択できるが、3つ以上では循環が生じ得ることを意味する。単峰性仮説のもとでは多数決決定が機能するが、現実の政治的選好分布がこの条件を満たす保証はない。

2. アルゴリズムバイアスの構造分析

人工知能や機械学習システムが社会的意思決定に関与する領域が拡大する中、アルゴリズムバイアスの問題が顕在化している。本章では、バイアスの発生メカニズムと、公平性概念の多様性について検討する。

2.1 アルゴリズムバイアスの発生機序

アルゴリズムバイアスとは、機械学習アルゴリズムや人工知能システムが、特定の属性やグループに対して不公平な結果を生み出す現象を指す。このバイアスは複合的な要因から発生する。

第一層:データバイアス

学習データに含まれる歴史的偏りが、モデルの出力に反映される。過去の採用データが特定の性別に偏っていれば、予測モデルもその偏りを学習する。

第二層:特徴量選択バイアス

間接的に差別を引き起こす特徴量の使用。郵便番号に基づくクレジットスコア予測は、地域的な社会経済的偏見を反映し得る。

第三層:アルゴリズム設計バイアス

最適化目標の設定自体が特定のグループに不利に働く場合がある。利益最大化のみを目標とするアルゴリズムは、社会全体の厚生を考慮しない。

2018年のAmazon社AI採用システム事例は、これらのバイアスが複合した典型例である。過去10年間の履歴書パターンを学習したシステムは、技術系職種において過去の採用実績が男性に偏っていたため、女性を示唆する単語が含まれる履歴書の評価を下げる傾向を示した。同社はこのシステムの使用を打ち切っている。

2.2 公平性定義の相互排他性

アルゴリズムバイアス研究において最も困難な問題の一つは、公平性の定義自体が複数存在し、それらが相互に排他的であり得るという点にある。機械学習の最適化を実現する上で、異なる公平性基準を同時に満たすことは数学的に不可能な場合が多い。

| 公平性の定義 | 数学的条件 | 限界 |

|---|---|---|

| 統計的パリティ | 予測結果がセンシティブ属性と独立 | 実質的な能力差を無視 |

| 機会の均等 | 真陽性率がグループ間で等しい | 偽陽性率の格差を許容 |

| 処理の平等性 | 同一特性には同一処理 | 過去の不平等を固定化 |

| 結果の平等性 | 全グループで同一結果 | 個人差の無視 |

| 反事実的公平性 | センシティブ属性変更時も同一結果 | 因果推論の困難さ |

これらの公平性基準は、多くの場合において同時に満たすことができない。例えば、グループ間の基礎的な分布が異なる場合、統計的パリティと機会の均等を同時に達成することは数学的に不可能である。この事実は、アローの不可能性定理と構造的に類似している。

2.3 最適化と公平性の相克

機械学習モデルの開発において、予測精度の最大化と公平性の確保は往々にしてトレードオフの関係にある。精度最適化のみを追求すれば、歴史的な偏りを反映したモデルが構築される。一方、厳格な公平性制約を課せば、予測性能が低下する可能性がある。

このトレードオフは、集団意思決定における効率性と公平性の古典的ジレンマを、技術的文脈において再現したものと解釈できる。多数決が全員の選好を完全に反映できないように、最適化アルゴリズムも全グループの利益を同時に最大化することはできない。

3. 相克を超えるための考察

前章までの分析を踏まえ、多数決とアルゴリズムの双方に内在する限界を認識した上で、より良い集団意思決定システムを構築するための方向性を検討する。

3.1 バイアス緩和技術の現状

アルゴリズムバイアスを軽減するための技術的アプローチは、介入のタイミングによって三種類に分類される。前処理手法は学習データの偏りを修正するものであり、Massagingやリサンプリングがこれに該当する。学習時手法はモデル訓練過程で公平性制約を組み込むものであり、制約付き最適化や敵対的学習が用いられる。後処理手法はモデル出力を調整するものであり、閾値の調整や予測の較正がこれに該当する。

バイアス緩和の実践的指針

- データ収集の多様性確保:学習データが多様なグループや状況を代表することを確認する。偏りのないデータセット構築が基盤となる。

- 複数の公平性指標の監視:単一の指標ではなく、統計的パリティ、機会の均等、予測値の較正など複数の観点から評価する。

- 継続的なモニタリング:運用開始後も定期的にバイアスを検出し、修正するプロセスを実施する。

- 多様なチーム構成:開発チームに異なるバックグラウンドを持つ人々を参加させ、多角的な視点からバイアスを発見する。

- 透明性の確保:意思決定プロセスを可能な限り公開し、外部からの検証を可能にする。

3.2 制度設計の観点

技術的対策だけでなく、制度設計の観点からの取り組みも重要である。EUの一般データ保護規則(2018年)や人工知能法案(2021年)は、アルゴリズムバイアスを法的枠組みの中で位置づける試みである。これらの規制は、アルゴリズムの説明責任と透明性を要求し、センシティブ属性に基づく差別的処理を制限する。

社会選択理論の観点からは、アローの不可能性定理の条件を部分的に緩和することで、実用的な意思決定制度を設計することが可能である。単峰性仮説のもとでは多数決制度が機能するように、アルゴリズムによる意思決定も、適切な前提条件のもとで公平性を担保できる可能性がある。

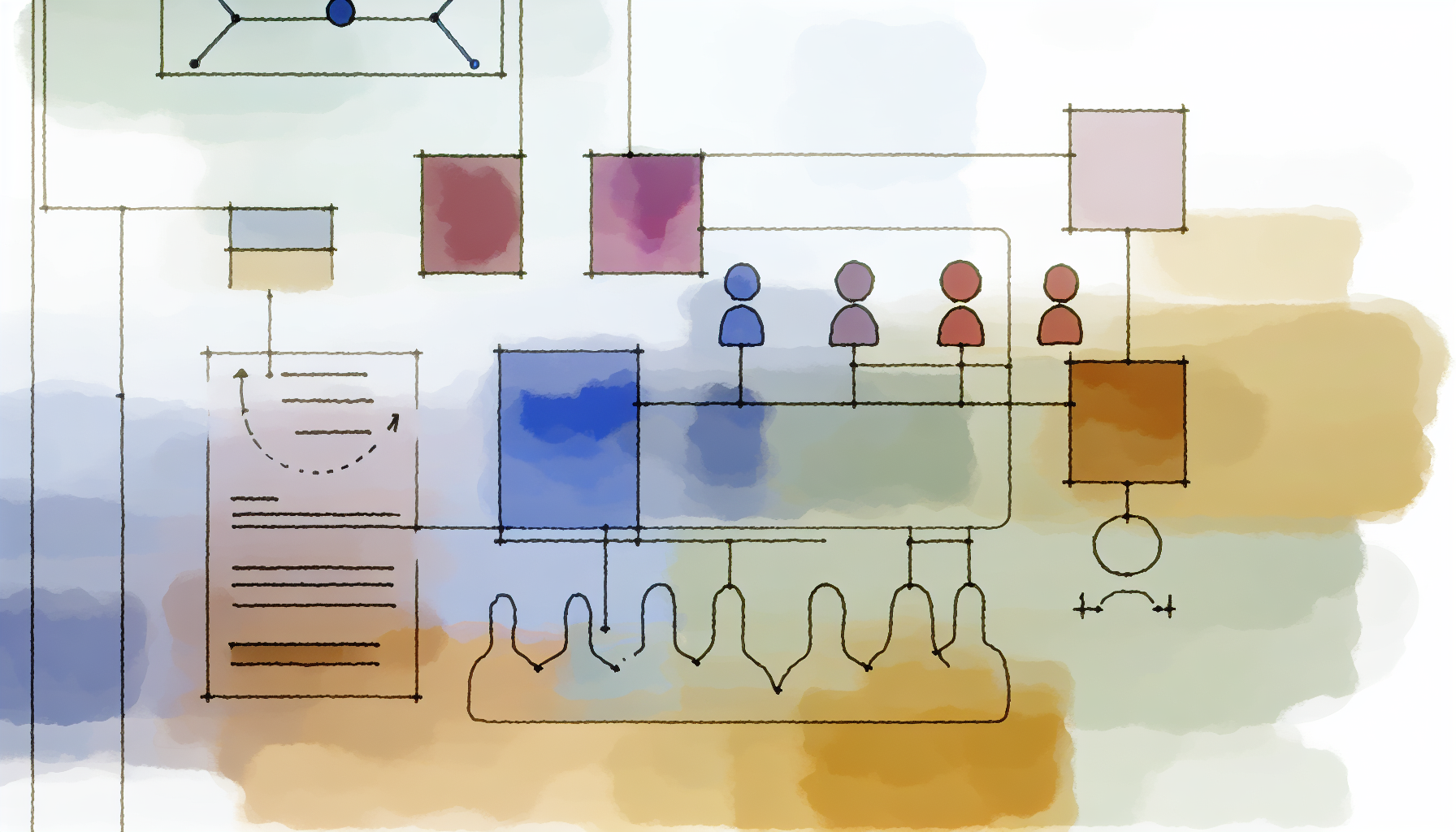

3.3 人間とアルゴリズムの協働

本考察から導かれる一つの方向性は、人間の判断とアルゴリズムによる支援を適切に組み合わせるハイブリッドアプローチである。アルゴリズムは大量のデータから一貫した基準で判断を下すことができるが、文脈依存的な価値判断や例外的状況への対応には限界がある。人間の判断は柔軟性に優れるが、認知バイアスや一貫性の欠如という問題を抱える。

重要なのは、アルゴリズムを意思決定の代替物としてではなく、人間の判断を補助する道具として位置づけることである。最終的な意思決定の責任は人間が負い、アルゴリズムは情報提供と選択肢の提示を担う。この分担により、効率性と説明責任の両立が可能になる。

3.4 今後の展望

集団意思決定におけるアルゴリズムバイアスの問題は、技術的課題であると同時に、民主主義の本質に関わる政治哲学的課題でもある。アローの不可能性定理が示すように、完璧に公平な意思決定システムは理論的に存在しない。しかし、この限界を認識した上で、よりマシなシステムを追求することは可能である。

アルゴリズムバイアスの研究者らは、公平性を直すことに焦点を合わせているが、公平性の定義は相互に、そして機械学習の最適化を実現するには両立しないことが多い。しかし、この限界を認識することこそが、より良いシステム設計の第一歩となる。

今後の研究と実践においては、以下の方向性が重要になると考えられる。文脈依存的な公平性基準の選択方法の確立、アルゴリズムの意思決定過程の説明可能性向上、多様なステークホルダーを巻き込んだ意思決定プロセスの設計、継続的な監視と改善のための制度的枠組みの構築である。

多数決という古典的な集団意思決定の仕組みと、最適化という現代的なアルゴリズム設計の原理は、ともに完璧ではない。しかし、その限界を数学的に理解することで、私たちはより賢明な制度設計を行うことができる。アローの不可能性定理が民主主義の終焉を意味しなかったように、アルゴリズムバイアスの存在もAI活用の放棄を意味しない。重要なのは、限界を認識した上で、不断の改善を続けることである。

本記事は2025年12月13日時点の情報に基づいて作成されています。記事内容は個人的な考察に基づくものであり、専門的な判断については関連分野の専門家にご相談ください。技術の進展は予測困難であり、本記事の予測や分析が外れる可能性も十分にあります。重要な決定については、複数の情報源を参考にし、自己責任で行ってください。

他の記事を見る(14件)

- 手書きの復権:AIに頼りすぎた人生が失うもの

- AIの内発的動機づけ:好奇心で動くエージェントの最前線

- AI2027レポート考察2025|元OpenAI研究者が描く3年後の衝撃シナリオ

- REL-A.I.研究考察2025|スタンフォードが明らかにした人間とAIの依存関係

- 言語モデルと脳の乖離研究2025|CMUが解明した人間とAIの3つの決定的な違い

- AIとの対話が言語思考に与える影響検討|認知的依存と自律性のバランス

- AI訓練データの著作権問題考察|クリエイター保護と技術発展のジレンマ

- Agentic AI Foundation設立考察2025|AnthropicがMCPを寄贈しAIエージェント標準化へ

- LLMの毒性出力リスク分析|安全性アライメント技術の現状と課題

- AIが生成する価値観の偏向性考察|システムプロンプトの倫理的責任

- AIによる患者データ分析の有効性検討|診断精度向上の可能性と限界

- 集団意思決定におけるアルゴリズムバイアス考察|多数決と最適化の相克

- ニューラルネットワーク解釈性の研究動向|ブラックボックス化を緩和する手法検討

- 中国AI規制の考察|世界初「感情安全性」に焦点を当てたチャットボット規制案

PR:関連サービス

PR:関連サービス

コメント (0)

まだコメントはありません。