機械学習・深層学習・生成AIの違いと関係性を整理して考える

機械学習・深層学習・生成AIの違いと関係性を整理して考える

更新日:2025年12月14日

1. 各技術の基本概念と定義

AI(人工知能)の分野では、複数の技術用語が混同されやすい状況にあります。まず、機械学習、深層学習、生成AIそれぞれの定義と特徴を整理していきます。

1.1 機械学習(Machine Learning)とは

機械学習とは、コンピュータが明示的にプログラムされることなく、データから自動的にパターンやルールを学習する技術です。アメリカの計算機科学者アーサー・サミュエル氏による定義では、「明示的にプログラムしなくても学習する能力をコンピュータに与える研究分野」とされています。

機械学習の学習方法は主に3種類に分類されます。「教師あり学習」は正解ラベル付きのデータから学習する方法で、スパムメールの分類や売上予測などに活用されます。「教師なし学習」は正解を与えずにデータの構造やパターンを発見する方法で、顧客のセグメンテーションなどに用いられます。「強化学習」は試行錯誤を通じて最適な行動を学習する方法で、ゲームAIやロボット制御などに応用されています。

機械学習では、人間がデータの「特徴量」(分析に用いる指標)を設計・設定する必要があります。例えば売上予測において「曜日が売上に影響する」という仮説があれば、曜日情報を特徴量として設定します。構造化されたデータ(数値、カテゴリなど)の分析に適しています。

1.2 深層学習(Deep Learning)とは

深層学習は機械学習の一手法であり、人間の脳の神経回路を模した「ニューラルネットワーク」を多層化(深層化)した構造を持つ学習手法です。「ディープラーニング」とも呼ばれ、4層以上のニューラルネットワークを用いるものを指します。

深層学習の最大の特徴は、人間が特徴量を設計する必要がなく、データから自動的に特徴を抽出できる点にあります。例えば画像認識において、従来の機械学習では「色」「形」「エッジ」など人間が特徴を指定する必要がありましたが、深層学習ではモデル自身が識別に有効な特徴を発見します。

この能力により、画像認識、音声認識、自然言語処理など、人間が特徴量を設定しにくい非構造化データの処理において飛躍的な性能向上を実現しました。一方で、大量のデータと計算リソースを必要とし、判断根拠が説明しにくい(ブラックボックス化)という課題も存在します。

1.3 生成AI(Generative AI)とは

生成AIとは、テキスト、画像、音声、動画などの新しいコンテンツを自律的に生成できるAI技術の総称です。従来のAIが「分類」や「予測」を主な目的としていたのに対し、生成AIは学習したデータのパターンに基づいて、これまで存在しなかった新しいコンテンツを創出できる点が特徴です。

生成AIの技術基盤には深層学習が用いられています。特にテキスト生成においては、2017年にGoogle研究者らが発表した「Transformer」アーキテクチャが基盤技術となっています。Transformerの「自己注意機構(Attention)」により、文脈を効率的に理解し、長い文章を処理することが可能になりました。

ChatGPTやGeminiなどの対話型AIサービスの基盤となっているのが「LLM(大規模言語モデル)」です。LLMは生成AIの一種であり、膨大なテキストデータから学習することで、自然言語の理解と生成に特化したモデルです。

生成AIにはテキスト生成(LLM)以外にも、画像生成に用いられるGAN(敵対的生成ネットワーク)やVAE(変分オートエンコーダ)、拡散モデルなど複数の技術が存在します。Stable DiffusionやDALL-Eなどの画像生成AIも、広義の生成AIに含まれます。

2. 技術的な関係性と階層構造

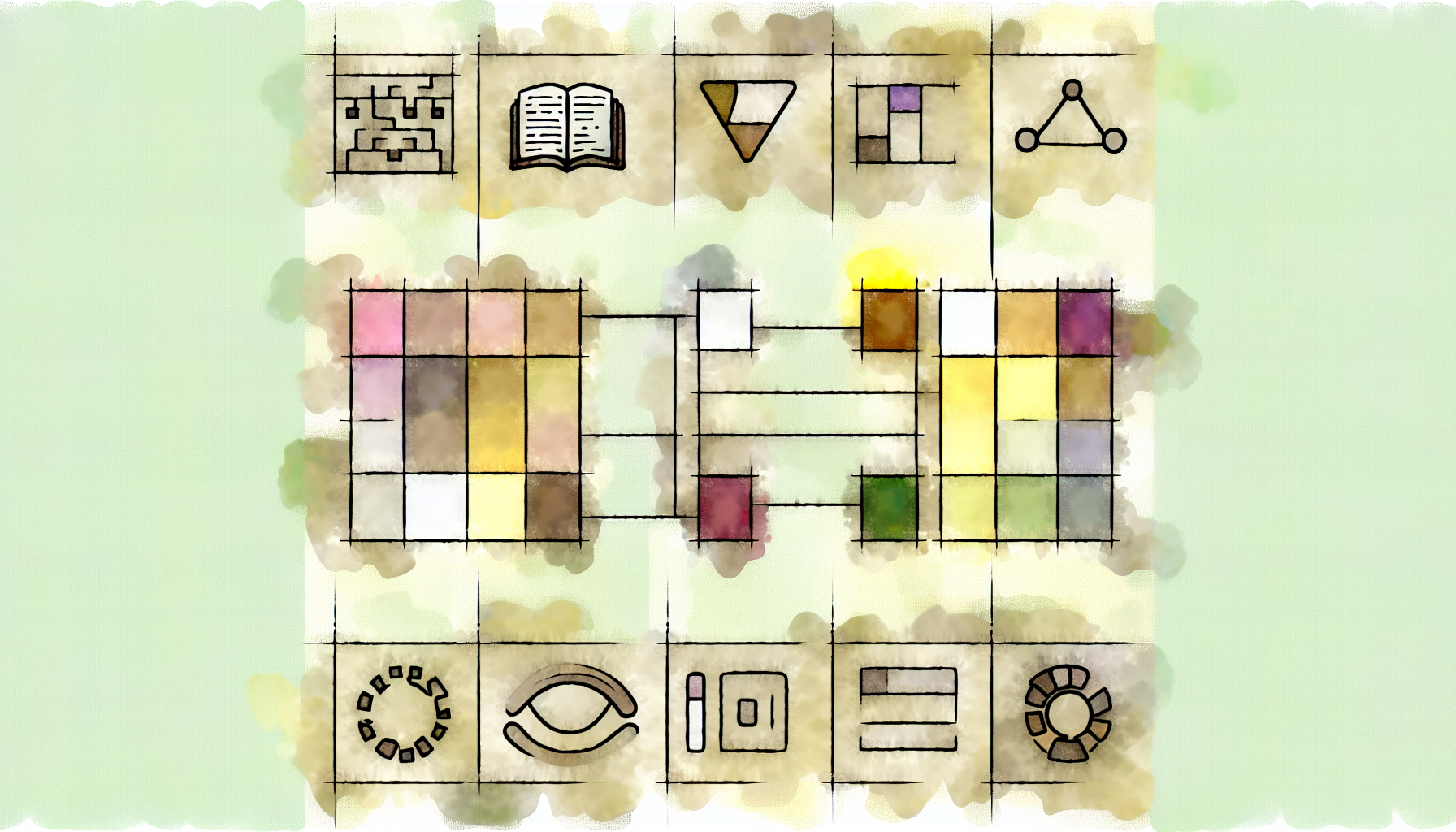

機械学習、深層学習、生成AIの関係は、単純な包含関係だけでは説明しきれない複雑さを持っています。ここでは、技術的な階層構造と発展の経緯を整理します。

2.1 包含関係と階層構造

これらの技術は基本的に「AI>機械学習>深層学習」という包含関係にあります。AIを実現するための手段の一つが機械学習であり、機械学習の手法の一つが深層学習という位置づけです。

生成AIについては、位置づけに注意が必要です。生成AIは「何を目的とするか」という観点での分類であり、技術的には深層学習を基盤としています。つまり、生成AIは深層学習の応用分野の一つとして捉えることができます。

2012年:深層学習が画像認識コンテストで圧倒的性能を示し、第3次AIブームが始まる

2017年:Google研究者がTransformerアーキテクチャを発表

2018年:GoogleがBERT(双方向言語モデル)を発表

2020年:OpenAIがGPT-3を発表、大規模言語モデルの可能性を示す

2022年:ChatGPT公開により生成AIが一般に普及、画像生成AIも話題に

2024年:GPT-4o、Gemini 2.0など、マルチモーダル対応モデルが登場

2.2 技術比較

各技術の特徴を比較すると、それぞれが得意とする領域や適用場面の違いが明確になります。

| 比較項目 | 機械学習 | 深層学習 | 生成AI |

|---|---|---|---|

| 主な目的 | 分類・予測・回帰 | 複雑なパターン認識 | 新規コンテンツ生成 |

| 特徴量設計 | 人間が設定 | 自動抽出 | 自動抽出 |

| 必要データ量 | 比較的少量で可 | 大量に必要 | 膨大に必要 |

| 計算リソース | 比較的軽量 | 高性能GPU必要 | 大規模インフラ必要 |

| 得意な入力 | 構造化データ | 画像・音声・テキスト | テキスト・画像等 |

| 解釈可能性 | 比較的高い | 低い(ブラックボックス) | 低い |

| 代表的手法 | 決定木、SVM、ランダムフォレスト | CNN、RNN、Transformer | LLM、GAN、拡散モデル |

2.3 予測AIと生成AIの違い

AIの活用目的という観点では、「予測AI」と「生成AI」という分類も有用です。予測AIは既存データに基づいて将来の値や分類結果を予測することを目的とし、これまでのAI活用の主流でした。一方、生成AIは入力に基づいて新しいコンテンツを創出することを目的としています。

同じ深層学習技術を用いていても、画像認識(予測AI)と画像生成(生成AI)では目的が異なります。この視点を持つことで、AI技術の適用場面をより適切に判断できるようになります。

3. 実践的な理解に向けて

技術の階層構造を理解した上で、実務や学習においてどのように活用すべきかを考察します。

3.1 技術選択の考え方

すべての課題に深層学習や生成AIが最適というわけではありません。データ量、計算リソース、解釈可能性の要求など、複数の要因を考慮した技術選択が重要です。

技術選択のポイント

- 構造化データの分類・予測:従来の機械学習(決定木、ランダムフォレストなど)が効率的な場合も多い

- 画像・音声・テキストの認識:深層学習が高い性能を発揮する領域

- 新規コンテンツの自動生成:生成AIの活用が適切

- 説明責任が求められる場面:解釈可能性の高い手法を優先する

- データ量が限られる場合:従来の機械学習や転移学習を検討する

3.2 学習ロードマップ

AI技術を体系的に学ぶ場合、以下のような段階的なアプローチが考えられます。基礎から応用へと積み上げることで、各技術の位置づけをより深く理解できるようになります。

まず統計学と線形代数の基礎を固め、次に機械学習の基本アルゴリズム(回帰、分類、クラスタリング)を学習します。その上でニューラルネットワークの仕組みを理解し、深層学習の各アーキテクチャ(CNN、RNN、Transformer)へと進みます。生成AIについては、LLMの仕組み、プロンプトエンジニアリング、RAG(検索拡張生成)などの応用技術を学ぶことで、実務での活用力を高められます。

3.3 今後の展望

AI技術は急速に発展を続けており、マルチモーダル(テキスト、画像、音声、動画を統合的に扱う)対応や、より長い文脈を理解できるロングコンテキスト対応など、新たな進化が続いています。一方で、ハルシネーション(事実と異なる内容の生成)、著作権問題、環境負荷など、解決すべき課題も存在します。

技術の進化に追従するためには、基礎概念の理解を土台として、継続的に最新動向をキャッチアップしていく姿勢が重要です。本記事で整理した階層構造を頭に入れておくことで、新しい技術が登場した際にも、その位置づけを適切に把握できるようになるでしょう。

本記事は2025年12月14日時点の情報に基づいて作成されています。AI技術は急速に発展しており、本記事の内容が最新の状況を反映していない可能性があります。記事内容は個人的な考察に基づくものであり、専門的な判断については関連分野の専門家にご相談ください。技術の進展は予測困難であり、本記事の記述が将来的に修正される可能性も十分にあります。

他の記事を見る(5件)

PR:関連サービス

PR:関連サービス

コメント (0)

まだコメントはありません。