研究開発におけるAIリテラシー考察|R&D現場で求められる新たな素養とは

研究開発におけるAIリテラシー考察|R&D現場で求められる新たな素養とは

更新日:2025年11月29日

研究開発分野におけるAIリテラシーの定義

研究開発分野におけるAIリテラシーは、一般的なビジネスパーソンに求められるそれとは質的に異なります。研究者・開発者には、AIを「便利なツール」として使うだけでなく、その原理を理解し、研究の信頼性や再現性を担保しながら活用する能力が求められます。

研究開発特有のAIリテラシーとは

一般的なAIリテラシーが「AIの基礎知識を理解し、正しく使いこなす能力」であるのに対し、研究開発分野では以下の要素が加わります。

第一に「科学的妥当性の評価能力」です。AIが出力した結果が科学的に妥当かどうかを判断できる必要があります。生成AIはハルシネーション(幻覚)を起こすことがあり、もっともらしい説明で誤った情報を出力することがあります。研究者はこれを見抜く批判的思考力を持たなければなりません。

第二に「再現性への配慮」です。研究の根幹である再現性を確保するため、AIをどのように使用したかを正確に記録・開示できることが求められます。プロンプトの内容、使用したモデルのバージョン、パラメータ設定などを適切に文書化する能力が必要です。

第三に「研究倫理との整合性」です。学術研究では、AIの使用が剽窃や不正行為に該当しないよう、倫理的な境界線を理解し遵守する必要があります。多くの学術誌がAI使用に関するガイドラインを定めており、これらを把握して適切に対応する能力が求められます。

JST研究開発戦略センターの報告によれば、現在の生成AIには「資源効率」「論理性・正確性」「実世界操作(身体性)」「安全性・信頼性」に課題があります。なぜ高い応答性能を示すのか、そのメカニズムすら完全には解明されていないことを、研究者は認識しておく必要があります。

データリテラシー・統計リテラシーとの関係

経済産業研究所(RIETI)の指摘によれば、AIリテラシーはデータリテラシーや統計リテラシーと密接に関連しています。AIの中心的な技術であるデータマイニングや機械学習を理解するには、データを探索的に解析する能力や、大規模データを統計的に処理する能力が前提となります。

研究開発者にとってのAIリテラシーは、これらの既存スキルの上に構築されるものです。AIが学習するデータの質と偏りを見極め、適切に前処理・可視化し、結果を統計的に解釈するスキルが基盤となります。

研究開発プロセスとAI活用の接点

研究開発において、AIは様々なフェーズで活用可能です。

| 研究フェーズ | AI活用例 | 求められるリテラシー |

|---|---|---|

| 文献調査 | 論文要約、関連研究の発見 | 情報の信頼性評価 |

| 仮説構築 | アイデア創出の壁打ち相手 | 批判的思考力 |

| 実験計画 | パラメータ最適化の提案 | 科学的妥当性の判断 |

| データ分析 | パターン発見、統計処理 | 結果の解釈能力 |

| 論文執筆 | 文章校正、翻訳支援 | 倫理ガイドラインの遵守 |

重要なのは、AIはあくまで研究者の思考を支援する「知的パートナー」であり、研究の本質的な価値を生み出すのは人間だという点です。AIが提供する情報や提案を鵜呑みにせず、専門知識に基づいて取捨選択できることが、研究開発者のAIリテラシーの核心といえます。

R&D現場でのAI活用の現状と課題

企業の研究開発部門や学術研究の現場では、AI活用が急速に進んでいます。しかし同時に、様々な課題も浮き彫りになっています。

企業R&D部門での導入状況

日鉄ソリューションズの調査(2025年9月)によれば、大企業において生成AIの活用が特に進んでいる部門として「法務・知財」「研究開発」が挙げられています。研究開発部門は、膨大な論文や特許情報の処理、実験データの分析など、AIとの親和性が高い業務を多く抱えているためです。

総務省の令和7年版情報通信白書によると、日本企業における生成AI利用率は55.2%に達しています。ただし、この数値は他国と比較すると低い水準にとどまっており、米国や中国との差が指摘されています。

2023年度:言語系生成AI導入済み企業 26.9%

2024年度:言語系生成AI導入済み企業 41.2%(+14.3ポイント)

2025年度:研究開発部門での活用が加速

研究開発現場が直面する課題

AI活用が進む一方で、研究開発現場には特有の課題が存在します。

第一に「知識の属人化と情報格差」です。研究開発現場では、ベテラン研究者に依存した研究ノート、個人PC内に閉じた実験データ、整理されない共有フォルダなど、情報格差による「研究の非対称性」が深刻化しています。若手・中堅研究者の成長速度が制約され、研究スピードや再現性、チーム連携に影響を及ぼしています。

第二に「効果的な活用方法の模索」です。総務省の調査では、生成AI導入に際しての懸念事項として日本企業が最も多く挙げたのは「効果的な活用方法がわからない」という点でした。導入しても期待通りの効果が得られないケースも多く、PwCの調査では日本企業で「期待を上回る効果」を実感している割合は米英の4分の1、独中の半分にとどまっています。

第三に「リテラシー格差の拡大」です。AIを積極的に活用する研究者とそうでない研究者の間で、生産性の差が広がっています。文部科学省のガイドラインでも「教員個人のデジタルリテラシーに大きく依存する」ことが課題として指摘されており、この格差を埋めるための体系的な研修プログラムの整備が急務となっています。

学術研究における倫理的課題

学術研究でのAI利用には、特有の倫理的課題があります。

学術論文でのAI利用における主な懸念

- オーサーシップの問題:ほとんどの学術誌はAIを著者として認めていない

- 意図せぬ剽窃リスク:AIが学習データのパターンを模倣・複製する可能性

- バイアスの再生産:AIのアルゴリズムに含まれる偏見が研究に影響

- ガイドラインの不統一:出版社・雑誌間でルールが異なる

BMJ誌に掲載された研究によれば、学術出版社および科学雑誌による著者への生成AI使用ガイダンスは不均一であり、何が許容される使用で何が不正かの境界線が明確でないケースも少なくありません。研究者には、投稿先のガイドラインを事前に確認し、AI使用を適切に開示する責任があります。

研究の質と信頼性への影響

AIへの過度な依存は、研究の質や信頼性を損なうリスクがあります。先行研究の分析においてAIを使用した研究によれば、学問の進展への貢献には「人間による解釈や洞察の統合、革新的な説明、理論の構築が必要」とされています。AIは大量の文献を効率的に処理・分析できますが、人間の研究者のように細やかに理解したり文脈を解釈したりすることはできません。

学術論文の執筆でAIだけに頼ると、人間ならではの専門性を失い、重要な知見を見逃したり、発見の重要性を誤解したりする恐れがあります。AIは研究者のアシスタントであり、批判的思考スキルや専門分野の知識に取って代わるものではないという認識が重要です。

研究開発者のためのAIリテラシー向上策

研究開発者がAIを効果的に活用するためには、体系的なリテラシー向上が欠かせません。具体的な方策を考察します。

技術的理解の深化

研究開発者には、AIの原理を概念的に理解することが求められます。ディープラーニングのアルゴリズムを自分で実装する必要はありませんが、AIがどのようにして出力を生成するのか、その仕組みを理解しておくことで、結果の妥当性を判断しやすくなります。

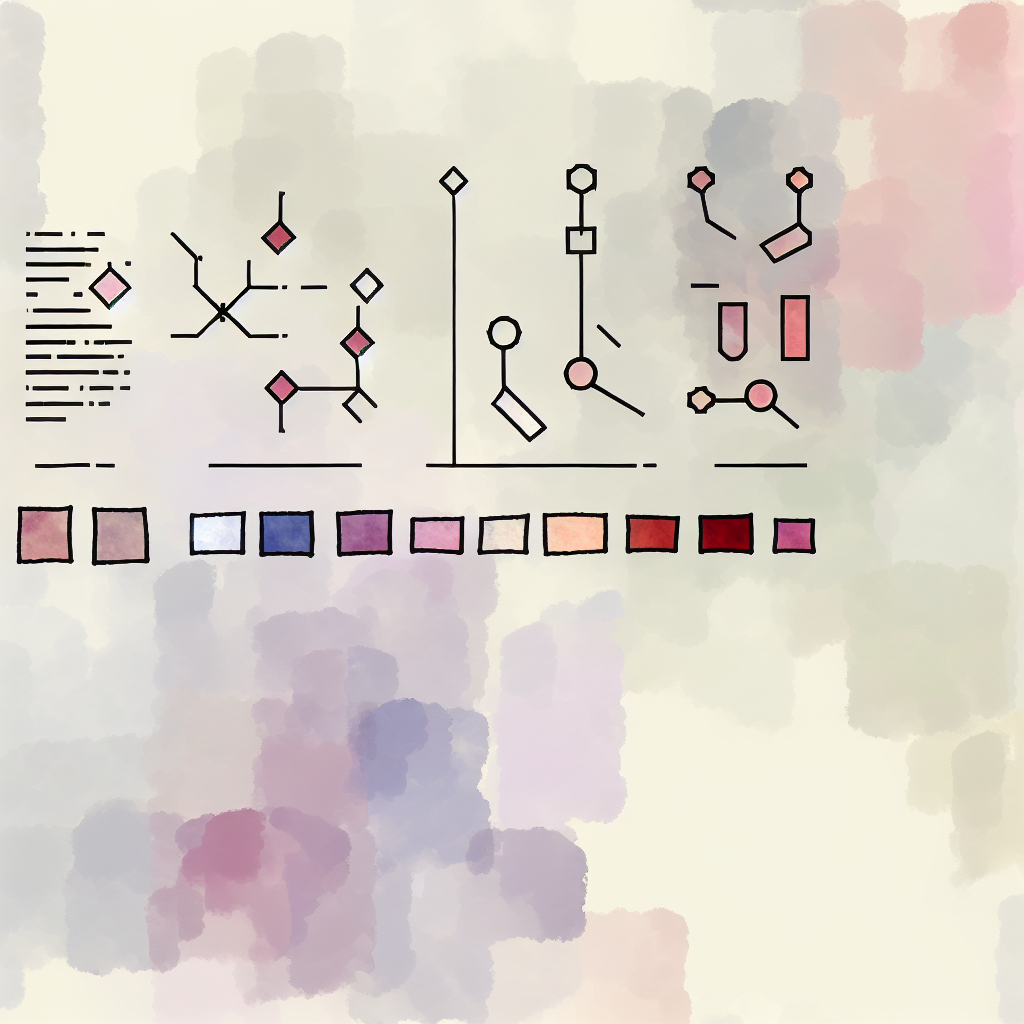

特に重要なのは、現在の基盤モデル・生成AIの限界を正確に把握することです。JST研究開発戦略センターは、以下の点を課題として挙げています。

| 課題領域 | 具体的な問題 |

|---|---|

| 資源効率 | 極めて大規模なリソース(データ、計算機、電力等)が必要 |

| 実世界操作 | 動的・個別的な実世界状況に適応した操作・行動が苦手 |

| 論理性・正確性 | 厳密な論理操作が苦手、ハルシネーションを起こす |

| 信頼性・安全性 | ブラックボックス性、動作や精度の完全保証は不可能 |

実践的な活用スキルの習得

研究開発現場でAIを活用するには、実践的なスキルが必要です。

研究者向けAI活用スキルセット

- プロンプトエンジニアリング:研究目的に適した指示文を設計する能力

- 出力の検証:AIの回答を別のソースで裏付ける習慣

- ツール選択:用途に応じた適切なAIツールを選べる判断力

- 記録・開示:AI使用の履歴を適切に文書化する能力

- セキュリティ意識:機密情報や個人情報をAIに入力しない判断

文献調査においては、ConsensusやConnected Papers、SciSpaceといった学術研究に特化したAIツールが有効です。これらは一般的な生成AIとは異なり、学術論文データベースに基づいて情報を提供するため、ハルシネーションのリスクが軽減されています。ただし、それでも出力結果の検証は必須です。

研究倫理とガイドラインの理解

学術研究でAIを利用する際は、倫理的な配慮が不可欠です。主要な学術出版社は、AI使用に関するガイドラインを定めています。

・AIを論文の著者として認めない

・AI使用を論文内で明確に開示することを求める

・AIが生成したコンテンツの正確性確認は著者の責任

・機密情報をAIモデルに入力しないよう注意喚起

研究者は、投稿先のジャーナルのガイドラインを事前に確認し、適切に対応する必要があります。ガイドラインは進化し続けているため、最新情報を常にキャッチアップする姿勢も重要です。

組織的な取り組み

個人のスキルアップだけでなく、組織としての取り組みも重要です。AIリテラシーの向上は組織全体で進める必要があります。

まず、研究開発部門内でのAI活用事例や失敗例を共有する仕組みが有効です。「プロンプト事故集」をナレッジベース化したり、良い使い方・危ない使い方を日常的に共有するチャンネルを設けたりすることで、属人化を防ぎ、全体的な安全活用が実現します。

また、継続的な研修機会の提供も不可欠です。AI技術と関連法規は半年単位で変化するため、定期的なアップデート研修を実施することで、組織全体のリテラシー水準を維持・向上させることができます。

研究の本質を見失わないために

最後に強調したいのは、AIはあくまで手段であり、研究の本質的な価値を生み出すのは人間だという点です。AIに頼りすぎると、研究者としての批判的思考力や創造性が低下するリスクがあります。

RIETIの指摘にあるように、AIリテラシーの本質は「これはAIでもできる、できない」と考えることを習慣にすることです。AIが自分の代わりにできる作業は任せつつ、AIにはできない自分の強み—独創的な仮説の構築、実験結果の深い解釈、新たな理論の提唱—への投資と学習を続けることが、研究者としての競争力を維持する鍵となります。

自分の持つ情報や知見が高い付加価値を生む可能性があるのかを考え、AIが代替できる仕事は手放す心の準備をしながら、人間にしかできない領域での専門性を磨き続けること。それが、AI時代における研究開発者のあるべき姿勢ではないでしょうか。

本記事は2025年11月29日時点の情報に基づいて作成されています。AI技術および関連制度は急速に変化しており、最新情報はJST研究開発戦略センター、文部科学省、各学術出版社等の公式サイトをご確認ください。記事内容は個人的な考察に基づくものであり、専門的な判断については関連分野の専門家にご相談ください。技術の進展は予測困難であり、本記事の予測が外れる可能性も十分にあります。

他の記事を見る(4件)

- AIリテラシーとは何か考察|AI時代に必要な「読み書き能力」の本質

- 研究開発におけるAIリテラシー考察|R&D現場で求められる新たな素養とは

- AIリテラシー教育の現状と課題を考察|学校現場での実践から見えてきたこと

- AI教育研究の最前線2025|ChatGPTは脳を退化させるのか

PR:関連サービス

PR:関連サービス

コメント (0)

まだコメントはありません。